In dieser Studie geht es um Untersuchungen zur Vorbeugung und Behandlung von Muskelkater bei Marathonläufern mittels Arnica D30. Darunter ist eine der Studien, die in der in 2005 erschienenen Metastudie von Shang als qualitativ hochstehend bewertet wurden. Nach Meinung der Autoren sei damit der Nachweis für eine Wirksamkeit des homöopathischen Präparats gelungen.

Vorbemerkung

Vor einiger Zeit hatte ich einen Fachaufsatz darüber geschrieben, welche Schwachstellen bei der Analyse von Studien zur Wirksamkeit der Homöopathie zu Tage getreten sind, und hatte ihn bei einer medizinischen Fachzeitschrift eingereicht. Vor ein paar Tagen erhielt ich die Mitteilung, dass er zur Veröffentlichung angenommen wurde; er wird demnächst in einem Peer-Review Journal erscheinen.

Für einen weiteren Aufsatz beschäftige ich mich nun hauptsächlich mit den Studien, die als positive Nachweise in die im Jahr 2005 veröffentlichte Metaanalyse von Shang eingeflossen sind. Diese Studien sind zwar schon etwas älter, wie auch diese hier, dennoch soll über sie berichtet werden.

Vorgehensweise

Es geht um Untersuchungen einer Gruppe von norwegischen Wissenschaftlern um D. Tveiten, die sich mit der Wirkung von Arnica D30 in der Vorbeugung und Behandlung von Erscheinungen beschäftigt, die wir allgemein als Muskelkater bezeichnen. Dazu wurden 1990 und 1995 beim Marathonlauf in Oslo in zwei praktisch identischen Versuchen 46 (1990) und 36 (1995) Läufer, also insgesamt 82, in jeweils zwei Gruppen aufgeteilt. Die eine erhielt Arnica D30 zur Vorbeugung und Behandlung von Muskelkater, die andere ein Placebo. Insgesamt gibt es darüber drei Berichte, wovon der dritte die Ergebnisse zusammenfasst, um eine größere statistische Sicherheit zu erlangen [1, 2, 3]. Wenn nicht anders angegeben, beziehen sich die Angaben in diesem Blogbeitrag auf die zusammengefassten Daten aus [3].

Es gibt eine kleine begriffliche Schwierigkeit. Der in der Studie verwendete Begriff ‚muscle soreness‘ beinhaltet alle Beschwerden in den Muskeln, die bei oder nach einer Anstrengung auftreten, der deutsche Begriff ‚Muskelkater‘ eigentlich nur diejenigen, die eine gewisse Zeit später auftreten. Der Einfachheit halber bin ich dennoch beim Muskelkater geblieben. Man wird den Unterschied merken, denn nach den Studienergebnissen traten die Beschwerden unmittelbar nach dem Lauf am stärksten auf, während der klassische Muskelkater sich erst am nächsten Tag vehement meldet.

Die Läufer waren alle männlich und im Durchschnitt 41 bis 42 Jahre alt. Von den insgesamt 82 Läufern erhielten 44 das Medikament Arnica D30 in Form von Globuli, die anderen 38 Läufer ein nicht zu unterscheidendes Placebo. Die Gruppeneinteilung wurde nach dem Zufallsprinzip vorgenommen, weder Teilnehmer noch Versuchsbetreuer hatten Kenntnis davon, wer Placebo oder das Homöopathikum erhielt. Die Läufer nahmen jeweils 5 Globuli am Abend vor dem Lauf ein und dann jeweils morgens und abends am Wettkampftag sowie an den nächsten drei Tagen.

Die Daten für diese Studie wurden unmittelbar vor dem Wettkampf, unmittelbar danach sowie 18, 42 und 66 Stunden nach dem Lauf ermittelt. Dabei wurde eine Blutprobe entnommen und die Versuchspersonen mussten ihr Befinden anhand einer Analogskala bewerten. Die Analogskala bestand aus einer 100 mm langen Linie, deren Anfangspunkt ‚kein Muskelkater‘, der Endpunkt mit ‚extremer Muskelkater‘ beschriftet waren. Die Bewertung erfolgte dadurch, dass die Versuchsteilnehmer die subjektive Beurteilung ihres Befindens auf dieser Skala markierten. Der Abstand der Markierung zum Anfangspunkt in Millimetern wurde dann als Messwert für das Befinden verwendet.

Die Blutproben wurden zentrifugiert und auf verschiedene Inhaltsstoffe untersucht, Enzyme, Elektrolyte, Stoffwechselprodukte, die im Zusammenhang mit körperlicher Belastung von Bedeutung sind.

Ergebnisse

Wer meinen Artikel über die Herstellung eines homöopathischen Mittels aus dem Wein des letzten Abendmahls (hier) noch gegenwärtig hat, der weiß, dass der letzte Becher Wein Jesu, verteilt auf den gesamten Wasservorrat der Erde, eine Konzentration ergibt, die einer homöopathischen Potenz zwischen D21 und D22 entspricht, etwa fünf Wassermoleküle pro Milliliter. Arnika D30 ist also noch mehr als einhundert Millionen mal stärker verdünnt. Arnica aus der Urtinktur ist in dem getesteten Medikament folglich nicht mehr enthalten. Eine Wirkung dieses Medikaments auf die Sportler wäre in der Tat eine Sensation.

Diese Sensation bleibt aber aus, denn die Ergebnisse der Blutproben zeigten keinerlei signifikanten Unterschied zwischen den Gruppen. Wie kommen die Autoren zu ihrer positiven Bewertung?

Lediglich die Selbstbewertung der Läufer zeigt Unterschiede:

In [3] ist das Ergebnis nur grafisch dargestellt, in [2] finden sich jedoch Zahlenangaben. Diese beziehen sich zwar nur auf die 36 Läufer aus dem Lauf in 1995, sind auch augenscheinlich etwas höher, aber vom Charakter und Verlauf her sehr ähnlich den Angaben in der zusammenfassenden Auswertung [3]. Anstelle einer notwendigerweise ungenauen grafischen Ermittlung werden daher die Angaben aus dem zweiten Lauf verwendet (s. Tabelle):

| Zeitpunkt | Arnica D30 | Placebo | Wahrscheinlichkeit |

|---|---|---|---|

| vor Lauf | 7,4 | 5,0 | 0,27 |

| nach Lauf | 62,7 | 72,8 | 0,017 |

| 0 A | 57,5 | 62,5 | 0,31 |

| 1 M | 53,5 | 60,9 | 0,27 |

| 1 A | 47,8 | 53,2 | 0,44 |

| 2 M | 40,0 | 43,5 | 0,47 |

| 2 A | 31,9 | 34,5 | 0,69 |

| 3 M | 20,7 | 17,7 | 0,60 |

| 3 A | 12,5 | 12,2 | 0,89 |

Bewertung der Intensität des Muskelkaters auf Analogskala (0 = kein, 100 = extrem stark)

1, 2, 3: Tag nach Wettkampf, M, A: morgens, abends

Hiernach bewerteten die Läufer der Placebogruppe ihren Muskelkater direkt nach dem Lauf bei 72,8 mm, die Läufer der Verumgruppe mit 62,7 mm, was in dieser Arbeit den einzigen (!) Vergleichswert der beiden Gruppen darstellt, der statistisch signifikant ist. Am Abend des letzten Tages lagen beide Gruppen gleichauf mit 12,5 (Homöopathie) und 12,2 mm (Placebo). Das heißt, die Heilung ist bei beiden Gruppen innerhalb von ungefähr 3,5 Tagen erfolgt, bei der Placebogruppe mit rund 17,3 mm pro Tag, bei der Verumgruppe nur mit rund 14,3 mm pro Tag.

Wir haben also jetzt die Auswahl, wie das Ergebnis zu bewerten ist. Entweder hat Arnica D30 tatsächlich gewirkt und einem Muskelkater vorgebeugt, dann hat es aber bei der Heilung versagt. Oder es hat bei der Vorbeugung nicht gewirkt – aber dafür bei der Genesung geschadet. Beide Alternativen enthalten jedoch eine Wirkung von Arnica D30, wenn auch nicht immer in der eigentlich angestrebten Richtung, könnten also als Wirkungsnachweise eines homöopathischen Mittels in Hochpotenz gelten.

Das Problem ist allerdings die subjektive Bewertung auf der Analogskala.

Bei allen Beschwerden und Therapien, die sich mit dem subjektiven Befinden, etwa Unwohlsein, Schwindel oder Schmerzen, befassen, hat man das Problem, während einer Therapie den Verlauf zu bewerten, ob eine Verbesserung erreicht wurde oder eine Verschlimmerung eingetreten ist. Dabei hat es sich bewährt, den Patienten sein Empfinden auf einer solchen Skala selbst bewerten zu lassen, die im englischen Schrifttum oft als VAS (‚visual analogue scale‘) bezeichnet wird. Entsprechend ist das Verfahren selbst Gegenstand vieler Untersuchungen betreffend der Zuverlässigkeit der gewonnenen Aussagen.

Wenn Versuchspersonen oder Patienten beispielsweise ihre aktuellen Schmerzen bewerten, besteht das Problem, dass Schmerzen unterschiedlich stark wahrgenommen werden können, auch wenn der Reiz der gleiche ist. Manche Menschen reagieren empfindlicher als andere, was auf sehr viele verschiedene Ursachen zurückzuführen ist. In Frage kommen etwa generelle persönliche Disposition, Gewöhnung, lokale Empfindlichkeiten aus früheren Schädigungen, sicherlich noch viel mehr, wenn man sich intensiver mit dem Thema beschäftigt.

Der zweite Punkt ist, dass die Skala selbst höchst individuell ist. Von den zwei Endpunkten ist nur einer eindeutig, nämlich ‚keine Beschwerden‘. Das andere Ende, ‚größtmögliche Beschwerden‘ oder ähnlich beschrieben, ist davon abhängig, was sich der Betreffende vorstellen kann oder was er schon an Erfahrungen hinter sich gebracht hat. Der Patient sollte also etwa wie folgt vorgehen: Er muss sich vorstellen, wie stark der stärkste Schmerz, den er sich vorstellen kann, sein könnte. Mit diesem eher diffusen Eindruck muss er sein gegenwärtiges Befinden vergleichen und dabei bewerten, ob sein Schmerz halb so groß ist, oder zwei Drittel oder was auch immer. Das Ganze läuft wahrscheinlich recht unbewusst ab. Entsprechend gut ist die Treffsicherheit.

Dennoch ist die VAS das einzige Instrument, um einen Sinneseindruck irgendwie zu quantifizieren, und wird daher oft angewandt, um den Fortschritt bei einem Patienten zu bewerten. Und genau dafür, den Fortschritt bei einem und demselben Patienten zu bewerten, ist die VAS vergleichsweise gut geeignet. Für einen einzigen Patienten sind die Dinge, die seine Bewertung beeinflussen, immer die gleichen. Was die VAS messen kann, ist die Veränderung, also ob der Patient nach ’50‘ nun ’70‘ oder ’30‘ bewertet, nicht ob der Ausgangspunkt des Ganzen bei ’50‘ oder ’60‘ oder ’40‘ liegt. Wichtig ist das ‚Besser‘ oder ‚Schlechter‘.

Hierfür gibt es auch einige Studien, die sich mit dem Messwerkzeug an sich befassen. In [4] wird beispielsweise ermittelt, dass bei Bewertung von Schmerzen ‚etwas besser‘ oder ‚etwas schlechter‘ etwa einer Änderung von 12 mm auf der VAS entspricht. Dies entspricht etwa die Auflösung des Verfahrens. Veränderungen in der Markierung, die geringer sind, deuten nicht auf eine tatsächliche Veränderung beim Patienten hin.

Aus Daten, die in [5] ermittelt wurden, kann man abschätzen, dass die Messunsicherheit im Vergleich zwischen Personen etwa dreimal so hoch sein kann wie die Streuung bei einem Patienten. Dies wurde jedoch für die Bewertung von Trainingsbelastungen ermittelt. Ob dies auf andere Sinneseindrücke, hier für den Muskelkater, auch zutrifft, ist zumindest fraglich, denn zwischen den verschiedenen Krankheitsbildern kann man diese Ergebnisse vermutlich nicht übertragen. Beispielsweise wurde in [6] festgestellt, dass bei Asthmapatienten die Selbstbewertung der Lungenfunktion mit objektiv messbaren Daten nur in sehr geringem Ausmaß zusammenpasst.

Quintessenz: Da die Selbstbewertung nur höchst subjektiv ist, ist ein Unterschied von etwa 10 mm praktisch ohne Aussagekraft. Es ist schlicht und einfach nicht nachvollziehbar, ob die Läufer, die mit ’70‘ bewertet haben, den Muskelkater auch tatsächlich um 16 % stärker erlitten haben als diejenigen, die ihren Zustand mit ’60‘ bewertet haben. Was sie erlebt haben, ist ein ziemlicher Muskelkater nach dem Lauf, der nach gut drei Tagen wieder weg war. Und das war für beide Gruppen gleich.

Hinzu kommt noch, dass die Befunde nur als Durchschnittswerte angeben wurden, ergänzt durch Angaben der Standardabweichungen als Maß für die Streuung der Daten. Durchschnittswerte haben das Problem, dass sie von einzelnen Extremwerten, die weit abseits der Gesamtheit liegen, stark beeinflusst werden. Dies wird in meinem Buch ausgiebig diskutiert. Wesentlich aussagekräftiger wäre der sogenannte Median, das ist der Wert, der von der einen Hälfte unterschritten, von der anderen aber übertroffen wird.

Zur Illustration, wie empfindlich der Durchschnitt auf geringe zufällige Änderungen reagieren kann, ein kleines hypothetisches Beispiel: Wenn in der Verumgruppe ein Teilnehmer zufällig keinen Muskelkater zu verzeichnen gehabt hätte, dann läge bei den restlichen der Durchschnitt bei 65,4 mm (anstelle 62,7). Wäre dieser Teilnehmer in der anderen Gruppe gewesen, bei sonst gleichen Daten, dann läge der Durchschnitt dort bei 69,6 anstatt 72,8 mm. Der Unterschied der Mittelwerte läge also nur noch bei 4,2 anstelle von 10,1 wie tatsächlich gemessen, alleine verursacht durch die zufällige Zuordnung eines ‚extremen‘ Läufers.

Signifikanz

Die Signifikanz sagt bekanntlich aus, ob das Ergebnis wahrscheinlich durch Zufall zustande gekommen ist oder nicht. Man errechnet die Wahrscheinlichkeit, mit der das Ergebnis auftreten würde, wenn eine bestimmte Grundannahme zutreffen würde. Im vorliegenden Fall nimmt man an, die beiden Gruppen wären gleich, das heißt, das Medikament hätte keinen Einfluss. Nach einem bestimmten, dem Problem angemessenen Verfahren errechnet man dann, mit welcher Wahrscheinlichkeit das gemessene Ergebnis auftritt. Hier hat man einen Wilcoxon-Rangsummen-Test ausgeführt und damit eine Wahrscheinlichkeit von p = 0,017 ermittelt, also 1,7 %. Da dies unter der prinzipiell willkürlich festgelegten Schranke von 5 % liegt, geht man davon aus, dass das Ergebnis sehr wahrscheinlich nicht zufällig zustande gekommen ist, die Grundannahme somit nicht stimmt. Wenn diese nicht stimmt, dann sind die beiden Gruppen wahrscheinlich nicht gleich, das heißt, das Medikament hatte wahrscheinlich einen Einfluss auf das Gruppenergebnis.

Was aus dieser kurzen Betrachtung herauskommen sollte, ist, dass es sich bei der Betrachtung der Signifikanz auch nur um Wahrscheinlichkeiten handelt, nicht um Gewissheiten. Das Ergebnis ist zwar nicht sehr wahrscheinlich, aber auch nicht unmöglich. Ähnlich wie beim Würfeln. Dreimal hintereinander eine Sechs zu würfeln ist zwar recht unwahrscheinlich, die Wahrscheinlichkeit beträgt bei einem einwandfreien Würfel nur 0,5% – aber es kommt vor, wie jeder aus eigener Erfahrung weiß, wenn er auch nur ein wenig mit Würfeln gespielt hat.

Nun haben wir hier die Situation, dass aus der Vielzahl der verglichenen Werte ein einziger aus der Mitte heraus als signifikant errechnet wurde. Nicht etwa ab einem bestimmten Zeitpunkt alle nachfolgenden Werte, was man erwarten würde, wenn die Wirkung irgendwann einsetzt und von Dauer ist. Dass nur ein Wert signifikant sein soll, lässt deutliche Zweifel an der Aussagekraft dieses singulären Werts aufkommen.

Zu der Problematik, dass in dieser Untersuchung multiple Hypothesentests eingesetzt wurden, und daher die Ermittlung der Signifikanz ohnehin sehr fragwürdig ist, siehe den Kommentar von Dierk D. vom 2.9.2013

Zusammen mit der sehr fragwürdigen Methode, mit der die Daten überhaupt ermittelt wurden, geht die Aussagekraft gegen Null. Man wird wohl weiter mit dem Muskelkater leben müssen. Das einzige wirksame Mittel wäre wohl gewesen, auf die Teilnahme am Marathonlauf zu verzichten…

Anmerkung:

Unglücklicherweise haben die Forscher nicht alle Daten vorgelegt – das wären auch sehr viele gewesen – um den Signifikanztest nachrechnen zu können. Führt man hingegen einen Student-T-Test aus, dann ergibt sich keine Signifikanz, was jedoch daran liegen kann, dass die Daten sehr stark von einer Normalverteilung abweichen. Was allerdings auch nur schwierig zu glauben ist. In der zusammenfassenden Arbeit hat man dann eine Varianzanalyse für den gesamten Verlauf ausgeführt und will auf einen Signifikanz von p = 0,04 gekommen sein – aber auch hierfür werden die Daten nicht angegeben, was allerdings ohne Weiteres möglich gewesen wäre. Rein mathematisch ergibt sich bei einer höheren Anzahl der Teilnehmer eine bessere Signifikanz, das Ergebnis steht also nicht unbedingt im Widerspruch zu den obigen Betrachtungen.

Zusammenfassung

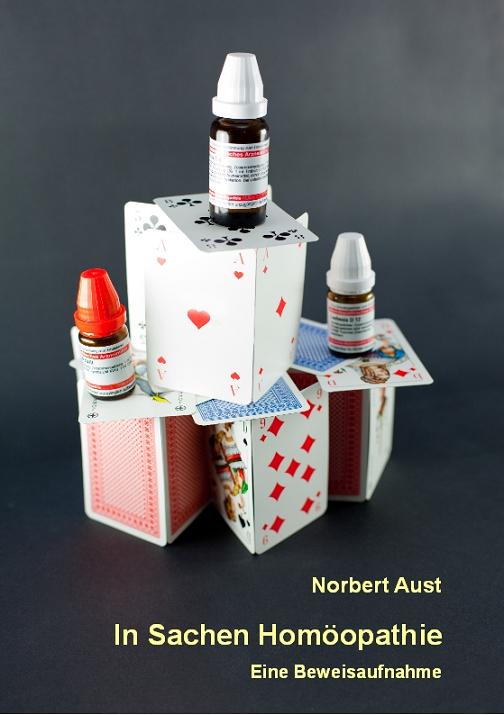

Bei insgesamt 82 Läufern aus zwei Marathonläufen im Stadtgebiet von Oslo wurde im Rahmen des Versuchs zu verschiedenen Zeitpunkten eine große Anzahl verschiedener Daten erhoben und diese miteinander verglichen. Von allen diesen Vergleichen hat nur ein einziger einen statistisch signifikanten Unterschied ergeben. Unverständlicherweise bringt dies die Autoren dazu, ihre Studie als einen positiven Wirkungsnachweis für das homöopathische Mittel zu bewerten. Dass die Werte für diesen einzigen Vergleich mit einem Verfahren ermittelt worden sind, das dafür überhaupt nicht geeignet ist, ist eigentlich schon fast nicht mehr der Rede wert.

Die Schlussfolgerung, dass der Nachweis der Wirkung von Arnica D30 gelungen sei, ist durch die in der Studie veröffentlichten Daten nicht gerechtfertigt.

Literatur

[1] Tveiten D, Bruset S, Borchgrevink CF, Lohne K. ‚Effect of Arnica D30 on hard physical exercise.‘ in Tidskr Nor Laegeforen 1991; 111: 3630-3631

[2] Tveiten D, Bruset S, Borchgrevink CF, Norseth J. ‚Effects of the homeopathic remedy Arnica D30 on marathon runners: a randomized, double-blind study during the 1995 Oslo Marathon‘, in: Complementary Therapies in Medicine (1998), 6, 71-74

[3] Tveiten D, Bruset S. ‚Effect of Arnica D30 in marathon runners. Pooled results from two double-blind placebo controlled studies‘, in: Homeopathy (2003) 92, 187-189

[4] Kelly AM. ‚The minimum clinically significant difference in visual analogue scale pain score does not differ with severity of pain‘ in: Emerg. Med. J 2001; 18: 205-207, Link zum Volltext

[5] Grant S, Aitchison T, Henderson E, Christie J, Zare S, McMurray J, Dargie M. ‚ A Comparison of the Reproducibility and the Sensitivity to Change of Visual Analogue Scales, Borg Scales, and Likert Scales in Normal Subjects During Submaximal Exercise‘ in: Chest 1999 116; (5): 1208-1217, Link zum Volltext

[6] Kendrick AH, Higgs CMB, Whitfield MJ, Laszlo G: ‚Accuracy of perception of severity of asthma: patients treated in general practice‘ in: BMJ 1993 307: 422-424, Link zum Volltext

Pingback: Von wegen “Potenz”: Kein besserer Sex mit Homöopathie @ gwup | die skeptiker

Vielen Dank für die Mühe. Klingt recht einleuchtend. Dann ist es wohl tatsächlich auch ein PRoblem, ob die Forscher korrekt über ihre Aktivitäten berichten.

Ich will es mal versuchen, von Hobby-Statistiker zu Hobby-Statistiker:

1) Ein Hypothesentest ist nur dann ein Hypothesentest, wenn die Hypothese vor der Auswertung festgelegt wird (einschließlich des Signifikanzniveaus). Wenn man das nicht macht, dann passt man nachträglich seine Hypothese an die Daten an, und das ist normalerweise falsch.

2) Meistens wird willkürlich ein Signifikanzniveau von 5% festgelegt. Das heißt, die Wahrscheinlichkeit ein falsch positives Ergebnis zu erhalten ist 5%. (Dementsprechend ist die Wahrscheinlichkeit kein falsch positives Ergebnis zu bekommen 95%).

3) Wenn man jetzt n Hypothesen auf einmal testet (zum Beispiel wie in dem diskutierten Paper 9 Zeitpunkte), dann ist die Wahrscheinlichkeit, dass man kein falsch positives Ergebnis bei einem Signifikanzniveau von 5% bekommt 95% hoch n, also 0.95^n, in diesem Beispiel: 0.95^9=0.63%. Dementsprechend ist die Wahrscheinlichkeit, mindestens ein falsch positives zu Ergebnis zu bekommen 0.47%. Rein durch Zufall würde man also in fast der Hälfte aller Studien mindestens ein falsch positives Ergebnis mit einem p-Wert von kleiner als 0.05 bekommen. Das kann nicht der Weisheit letzter Schluss sein. Zum Beispiel des Muskelkater-Papers: Die Wahrscheinlichkeit, dass man bei 9 Hypothesentests (unter der Annahme, dass die Nullhypothese gilt) zufällig einen dabei hat, der einen p-Wert von 0.017 oder kleiner liefert ist 0.143, und das ist weit weg von jeder statistischen Signifikanz.(Rechnet sich entsprechend zu oben aus 1-0.983^9 = 0.143)

4) Deshalb muss man bei multiplen Tests eben die p-Werte korrigieren. Bei wenigen Tests wie in diesem Beispiel kann man die Bonferroni-Korrektur bei der man die p-Werte mit der Anzahl der Tests multipliziert verwenden.

Soweit so gut. Das Problem dabei ist natürlich, dass man sich diese Korrektur mit einem Preis erkauft, nämlich dass man dann mehr falsch negative Ergebnisse in Kauf nimmt. Es könnte ja sein, dass einer der Parameter tatsächlich einen echten Effekt hat.

Deshalb ist eine alternative Betrachtung, dass man in so einem Fall, wo man 9 Zeitpunkte vergleicht eigentlich nicht wirklich eine Hypothese testet (und auch nicht die Hypothese an die Daten anpasst), sondern dass man eine Hypothese generiert. In diesem Fall dass der Effekt direkt nach dem Marathonlauf echt ist. Man kann allerdings nicht eine Hypothese auf den gleichen Daten generieren und testen. Deshalb muss man dann ein Validierungsexperiment machen, in dem man genau die eine Hypothese testet, die man vorher generiert hat.

Also (das ist meine Meinung als Hobby-Statistiker): Entweder die p-Werte für multiple Tests korrigieren ODER eine unabhängige Validierung machen. (Die unabhängige Validierung braucht n dem Fall nicht unbedingt ein neues Experiment, man kann auch die Hälfte der Originaldaten zufällig auswählen, zur Seite legen; mit der einen Hälfte Hypothese generieren und mit der anderen Hälfte testen).

Man kann hier mehrere Punkte einwenden: Die Autoren könnten darauf abstellen, dass sie gar keine einzelnen Zeitpunkte vergleichen wollten, sondern die Zeitliche Entwicklung. Dann ist allerdings die Frage, warum sie die Einzelzeitpunkte verglichen haben (wohl um den niedrigen p-Wert mitzunehmen). Der Zeitpunkt direkt nach dem Lauf ist ja schon ein spezieller.

Man muss den Autoren übrigens hoch anrechnen, dass sie alle Zeitpunkte veröffentlicht haben. Wissenschaftlich nicht korrekt aber auch nicht unüblich wäre, nur den Zeitpunkt nach dem Lauf und nach 3 Tagen zu nehmen und zu behaupten, dass das die Hypothese ist, die man von Anfang an testen wollte. Dann hätte man als Leser überhaupt keine Chance darauf zu kommen, dass man hier mit multiplen Tests zu tun hat.

Da kommt jetzt etwas ins Spiel, was ich – nur ein ‚Gelegenheitsstatistiker‘ – nie so richtig verstanden habe, nämlich die Korrektur der Signifikanz, wenn mehrere Nullhypothesen getestet werden. Da ich glaube, mit diesem Nichtverstehen nicht alleine zu sein, frage ich hier einmal nach:

In der zitierten Studie wurden eine ganze Reihe Vergleiche ausgeführt, nur einer davon war signifikant. Mir ist völlig klar, dass dann die Nullhypothese ‚Das Mittel ist unwirksam‘ nur abgelehnt werden kann, wenn die Wahrscheinlichkeit für dieses eine angeblich signifikante Ergebnis mit der Anzahl der getesteten Nullhypothesen multipliziert wird, um die Signifikanz für das Gesamtergebnis ‚Das Mittel hat eine Wirkung‘ zu bestimmen. Wenn man öfter würfelt, steigt die Wahrscheinlichkeit, dabei eine Sechs zu erhalten. Soweit so klar.

Warum aber ist die Signifikanz des Einzelergebnisses – ‚Das Mittel wirkt unmittelbar nach dem Lauf‘ – durch die anderen Nullhypothesen beeinflusst? Warum müsste ich, um dieses Ergebnis zu überprüfen, eine neue Versuchsreihe fahren, warum kann man dieses Teilergebnis nicht an dem vorliegenden Datensatz testen? Warum kann man aus dem vorliegenden Ergebnis nicht ableiten, dass die Schwere des Muskelkaters bei den Teilnehmern, die das Mittel angewendet haben, unmittelbar nach dem Lauf signifikant geringer war?

Könnten Sie mir da etwas aufs Pferd helfen?

Man muss gar nicht so weit gehen und die verwendete Skala und die Verteilungen der Messwerte anzweifeln. In diesem Fall wurden ja multiple Hypothesentests verwendet. Wenn man mehr als eine Hypothese testet, dann steigt ja die Wahrscheinlichkeit, dass eine falsch positive dabei ist, deshalb muss man eigentlich die p-Werte für die multiplen Tests korrigieren. Die einfachste Korrektur ist die nach Bonferroni, dabei werden die p-Werte mit der Anzahl der Tests multipliziert. Es ist aber egal welche Methode man anwendet, nach der Korrektur der Daten in der Tabelle ist kein Wert mehr signifikant (der kleinste p-Wert ist dann 0.153). Ich nehme an, dass in der Arbeit keine Korrektur durchgeführt wurde?

Natürlich kann man multiple Hypothesentests in der Forschung nicht vermeiden.

Wenn man die Korrektur vermeiden will, dann muss man aber der Ehrlichkeit halber sagen, dass man dann in Wirklichkeit keine Hypothese testet, sondern eine generiert.

Man müsste ja nur 20 Zeitpunkte nehmen und hätte ziemlich sicher einen p-Wert unter 0.05 dabei…

So wäre das Ergenis nur dann spannend, wenn man es in einem weiteren Versuch dann als einzige Hypothese testet und reproduziert.

Pingback: Cooles Video: Homöopathie – Alternative oder Glaube? @ gwup | die skeptiker

Ja eben. Einerseits wollte ich etwas Neues anbringen und andrerseits sinds die, die am Ende übrigbleiben – nachdem alle anderen wg methodischer Problemzonen entsorgt werden konnten.

Sehe ich nicht, bis auf einige Einzelfälle, bei denen sich mir alles sträubt, den Jagdschein auszustellen. Wenn raten angesagt sein sollte, käme mir eine völlig andere Erklärung in den Sinn.

@ Andreas:

Der 100. Komment wäre es doch wert, mit einem Vinum Christi anzustoßen!

Fehler in der Datenermittlung liegen z. B. vor, wenn nicht beachtet wurde, dass die Messung der Daten garnicht die Genauigkeit liefern kann, die im Ergebnis dargestellt wird, wie z. B. in der ADHS-Untersuchung von Frei, den Versuchen an Wasserlinsen und viele andere mehr. Oder die Verwendung von Messverfahren für Einsatzfälle, für die sie nicht validiert sind (Krebsstudie von Rostock oder auch Tveitens Studie zu Arnica D30 bei Muskelkater)

Dann gibt es Vergleiche von Daten, die nicht vergleichbar sind, weil nicht auf den gleichen Bezugspunkt bezogen (Krebsstudie von Rostock).

Gelegentlich werden auch Erfolge der homöopathischen Behandlung zugeordnet, die sehr wahrscheinlich eher von der begleitenden Therapie ausgelöst sind (Studie zum kindlichen Durchfall von Jacobs).

Oder die nicht nachvollziehbare Festlegung des Hauptergebnisses bei der Studie zu den grippalen Infekten von Rapp und vorher Ferley.

Ich will nicht so weit gehen, hier einen Vorsatz zu unterstellen, daher bezeichne ich diese ‚Ungereimtheiten‘ einfach als Fehler in der Datenermittlung.

Alle genannten Studien wurden hier in diesem Blog analysiert.

P.S. Gratulation an Andreas: Dies ist der 100. Kommentar auf diesem Blog.

Erst ein Mal Glückwunsch zur Veröffentlichung.

ganz elementare Fehler bei der Datenermittlung, der Auswertung und der Interpretation gemacht. Ich frage mich, ob das Methode hat.

Ich würde mich freuen, wenn es Methode wäre, dann würde man diese Betrüger eventuell mal dingfest machen können. Allerdings zeigt mir meine Erfahrung mit Medizinern und auch mit vielen Naturwissenschaftlern, dass viele gar keine Ahnung von Statistik haben, selbst wenn sie schon einige Veröffentlichungen hinter sich gebracht haben.

Traurig aber wahr.

Dr. Breß

Hallo, inwiefern werden Fehler in der Datenermittlung gemacht? Ich kann das gerade nicht nachvollziehen, wie du das gemeint hast und anhand welchen Ereignissen du das nachvollziehen kannst.

Na klar. Der Aufsatz wird dann auch in deutscher Übersetzung hier erscheinen.

Das ist es in allen (!) Fällen, die ich bisher bearbeitet habe, eben nicht: Es werden einfach ganz elementare Fehler bei der Datenermittlung, der Auswertung und der Interpretation gemacht. Ich frage mich, ob das Methode hat.

Glückwunsch! Wann und wo wird ja sicherlich noch nachgeliefert…

Nicht nur egal, sondern im Gegenteil: Da speziell in nicht daten-, sondern glaubensbasierten Weltbeschreibungen die aus irgendwelchen Gründen (zB statistische Ausreißer) entstandenen positiv bewerteten Studien wie rettungslos verlorene Zombies immer wieder ans Tageslicht der Diskussion gezerrt werden, ist es ungemein praktisch, wenn ein Index in Studien-Dekonstruktionen gesammelt werden kann.

Da darfst Du gerne weiter zu beitragen 😉